davincidig/iStock via Getty Images

davincidig/iStock via Getty Images

¿Alguna vez has tenido la experiencia de releer una frase varias veces y darte cuenta de que sigues sin entenderla? Como se les enseña a decenas de estudiantes universitarios de primer año, cuando te das cuenta de que estás perdiendo el tiempo, es hora de cambiar tu enfoque. Este proceso, darse cuenta de que algo no funciona y luego cambiar lo que estás haciendo, es la esencia de la metacognición, o pensar sobre el pensamiento.

Es tu cerebro monitoreando su propio pensamiento, reconociendo un problema y controlando o ajustando tu enfoque. De hecho, la metacognición es fundamental para la inteligencia humana y, hasta hace poco, ha sido poco estudiada en los sistemas de inteligencia artificial.

Mis colegas Charles Courchaine, Hefei Qiu y Joshua Iacoboni, y yo estamos trabajando para cambiar esto. Hemos desarrollado un marco matemático diseñado para permitir que los sistemas de IA generativa, específicamente los grandes modelos de lenguaje como ChatGPT o Claude, monitoricen y regulen sus propios procesos “cognitivos” internos. En cierto sentido, se puede considerar como un monólogo interno para la IA generativa, una forma de evaluar su propia confianza, detectar la confusión y decidir cuándo reflexionar más sobre un problema.

Por qué las máquinas necesitan autoconciencia

Los sistemas de IA generativa actuales son notablemente capaces, pero fundamentalmente inconscientes. Generan respuestas sin saber realmente cuán seguras o confusas podrían ser, si contienen información contradictoria o si un problema merece atención adicional. Esta limitación se vuelve crítica cuando la incapacidad de la IA generativa para reconocer su propia incertidumbre puede tener graves consecuencias, especialmente en aplicaciones de alto riesgo como el diagnóstico médico, el asesoramiento financiero y la toma de decisiones en vehículos autónomos.

Por ejemplo, considera un sistema de IA generativa médica que analiza síntomas. Podría sugerir con seguridad un diagnóstico sin ningún mecanismo para reconocer situaciones en las que sería más apropiado detenerse y reflexionar, como “Estos síntomas se contradicen” o “Esto es inusual, debería pensarlo con más cuidado”.

Desarrollar esta capacidad requeriría metacognición, que implica tanto la capacidad de monitorizar el propio razonamiento a través de la autoconciencia como de controlar la respuesta mediante la autorregulación.

Inspirado en la neurobiología, nuestro marco de trabajo busca dotar a la IA generativa de una semejanza con estas capacidades mediante lo que llamamos un vector de estado metacognitivo, que es esencialmente una medida cuantificada del estado “cognitivo” interno de la IA generativa en cinco dimensiones.

5 dimensiones de la autoconciencia de la máquina

Una forma de pensar en estas cinco dimensiones es imaginar que un sistema de IA generativa cuenta con cinco sensores diferentes para su propio pensamiento.

- Conciencia emocional, para ayudarle a rastrear contenido con carga emocional, lo cual podría ser importante para prevenir resultados perjudiciales.

- Evaluación de la corrección, que mide la confianza del modelo de lenguaje general en la validez de su respuesta.

- Coincidencia de experiencias, donde comprueba si la situación se asemeja a algo que ya ha experimentado.

- Detección de conflictos, para poder identificar información contradictoria que requiere resolución.

- Importancia del problema, para ayudarle a evaluar los riesgos y la urgencia de priorizar recursos.

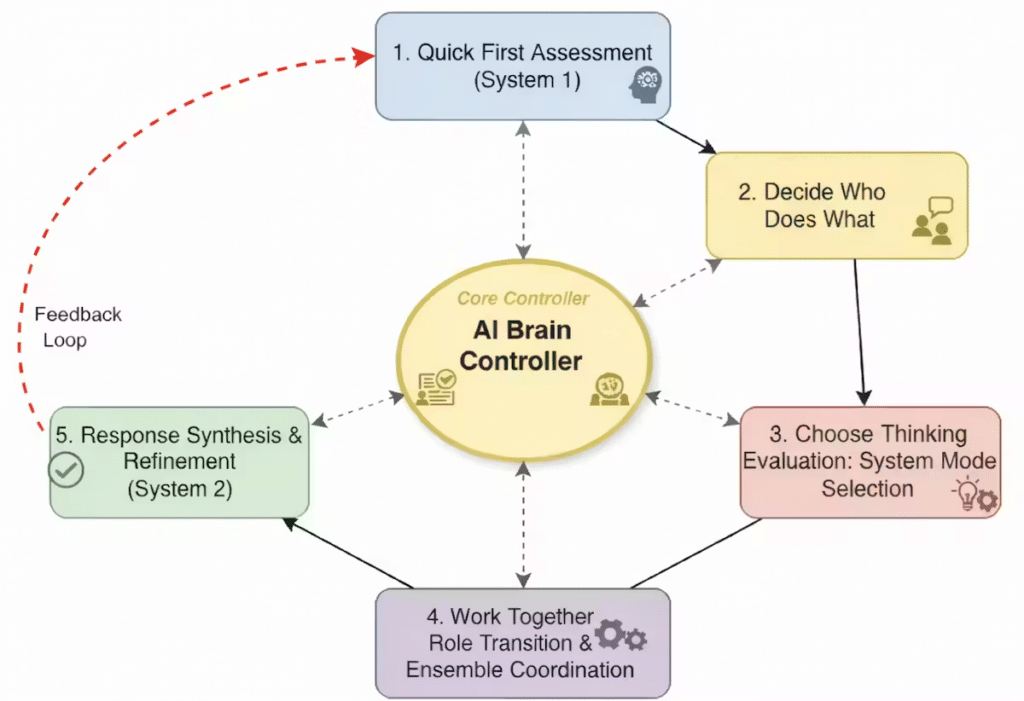

Cuantificamos cada uno de estos conceptos dentro de un marco matemático general para crear el vector de estados metacognitivos y utilizarlo para controlar conjuntos de grandes modelos lingüísticos. En esencia, el vector de estados metacognitivos convierte las autoevaluaciones cualitativas de un gran modelo lingüístico en señales cuantitativas que puede utilizar para controlar sus respuestas.

Por ejemplo, cuando la confianza de un gran modelo lingüístico en una respuesta cae por debajo de cierto umbral, o los conflictos en la respuesta superan ciertos niveles aceptables, podría pasar de un procesamiento rápido e intuitivo a un razonamiento lento y deliberativo. Esto es análogo a lo que los psicólogos denominan pensamiento del Sistema 1 y del Sistema 2 en humanos.

Dirección de orquesta

Imagine un gran conjunto de modelos lingüísticos como una orquesta donde cada músico —un gran modelo lingüístico individual— interviene en momentos determinados según las indicaciones del director. El vector de estados metacognitivos actúa como la conciencia del director, monitorizando constantemente si la orquesta está en armonía, si alguien está desafinado o si un pasaje particularmente difícil requiere atención adicional.

Al interpretar una pieza conocida y bien ensayada, como una simple melodía folclórica, la orquesta toca fácilmente al unísono, de forma rápida y eficiente, con mínima coordinación. Este es el modo del Sistema 1. Cada músico conoce su parte, las armonías son sencillas y el conjunto funciona casi automáticamente.

Pero cuando la orquesta se enfrenta a una composición de jazz compleja con compases conflictivos, armonías disonantes o secciones que requieren improvisación, los músicos necesitan una mayor coordinación. El director les indica que cambien de roles: algunos se convierten en líderes de sección, otros proporcionan anclaje rítmico y los solistas emergen para pasajes específicos.

Este es el tipo de sistema que esperamos crear en un contexto computacional mediante la implementación de nuestro marco, orquestando conjuntos de grandes modelos lingüísticos. El vector de estado metacognitivo informa a un sistema de control que actúa como director, indicándole que cambie de modo al Sistema 2. Entonces, puede indicar a cada gran modelo lingüístico que asuma diferentes roles (por ejemplo, crítico o experto) y coordinar sus complejas interacciones basándose en la evaluación metacognitiva de la situación.

Las implicaciones van mucho más allá de hacer que la IA generativa sea ligeramente más inteligente. En el ámbito sanitario, un sistema de IA generativa metacognitiva podría reconocer cuándo los síntomas no coinciden con los patrones típicos y derivar el problema a expertos humanos en lugar de arriesgarse a un diagnóstico erróneo. En educación, podría adaptar las estrategias de enseñanza al detectar la confusión de los estudiantes. Para la moderación de contenido, podría identificar situaciones con matices que requieren juicio humano en lugar de aplicar reglas rígidas.

Quizás lo más importante es que nuestro marco de trabajo hace que la toma de decisiones mediante IA generativa sea más transparente. En lugar de una caja negra que simplemente produce respuestas, obtenemos sistemas que pueden explicar sus niveles de confianza, identificar sus incertidumbres y demostrar por qué eligieron determinadas estrategias de razonamiento.

Esta interpretabilidad y explicabilidad es crucial para generar confianza en los sistemas de IA, especialmente en industrias reguladas o aplicaciones críticas para la seguridad.

El camino a seguir

Nuestro marco de trabajo no otorga a las máquinas conciencia ni autoconciencia real en el sentido humano. En cambio, nuestra esperanza es proporcionar una arquitectura computacional para asignar recursos y mejorar las respuestas, que también sirva como primer paso hacia enfoques más sofisticados para la metacognición artificial completa.

La siguiente fase de nuestro trabajo consiste en validar el marco mediante pruebas exhaustivas, medir cómo la monitorización metacognitiva mejora el rendimiento en diversas tareas y ampliarlo para comenzar a razonar sobre el razonamiento, o metarrazonamiento. Nos interesan especialmente los escenarios donde reconocer la incertidumbre es crucial, como en los diagnósticos médicos, el razonamiento legal y la generación de hipótesis científicas.

Nuestra visión final son sistemas de IA generativa que no solo procesen información, sino que comprendan sus limitaciones y fortalezas cognitivas. Esto significa sistemas que sepan cuándo confiar y cuándo ser cautelosos, cuándo pensar rápido y cuándo ir más despacio, cuándo están capacitados para responder y cuándo deben ceder ante otros.

Ricky J. Sethi es profesor de Ciencias de la Computación en la Universidad Estatal de Fitchburg y el Instituto Politécnico de Worcester.

Este artículo se retoma de The Conversation bajo una licencia de Creative Commons. Lee el original aquí.

![[Ilustración de origen: Freepik]](https://fc-bucket-100.s3.amazonaws.com/wp-content/uploads/2026/02/03093734/p-91480904-pros-and-cons-of-workplace-perfectionism.webp)

![[Foto: Manfrotto/Layer Design]](https://fc-bucket-100.s3.amazonaws.com/wp-content/uploads/2026/02/03095920/001-91484810-manfrotto-tripod.webp)

![[Foto: New Africa/Adobe Stock]](https://fc-bucket-100.s3.amazonaws.com/wp-content/uploads/2026/02/03072824/p-1-91485243-what-is-vagueposting-the-cryptic-social-media-trend-thats-driving-everyone-crazy.webp)

![Un podcast narrado por Kratos de God of War sería un experiencia auditiva muy peculiar. [Imagen: PlayStation]](https://fc-bucket-100.s3.amazonaws.com/wp-content/uploads/2026/02/03090535/Diseno-sin-titulo-2026-02-03T090515.010.jpg)

![[Imagen: envato]](https://fc-bucket-100.s3.amazonaws.com/wp-content/uploads/2026/01/30130432/openai-latam-chatgpt-go.png)